Energiefresser Künstliche Intelligenz: Die dunkle Seite der Innovation

Im Jahr 2026 werden Rechenzentren so viel Energie verbrauchen wie Schweden

© Getty Images

LIFESTYLE Klimawandel

Künstliche Intelligenz ist die Zukunft, aber erhöht sie auch den Verbrauch nicht nachhaltiger Energie? Darauf deuten zumindest die Zahlen hin. Laut der Internationalen Energieagentur (IEA) verbrauchte KI 2022 2 % der weltweiten Energie. Bis 2026 soll sich diese Zahl um bis zu 130 % erhöhen. Das entspricht dem Jahresverbrauch an Energie von Schweden. ExpertInnen sorgen sich um den riesigen Ressourcenverbrauch, der für KI nötig ist und warnen davor, dass die Umweltschäden nur noch weiter zunehmen werden.

Klicken Sie weiter, wenn Sie mehr über den besorgniserregenden Energieverbrauch von KI erfahren wollen.

Energieverbrauch von KI

KI macht bereits jetzt 1 bis 2 % des weltweiten Energieverbrauchs aus. 2022 verbrauchten Rechenzentren 460 Terrawattstunden, was dem Energieverbrauch von Frankreich entspricht. Konservativen Schätzungen zufolge wird sich der Verbrauch bis 2026 mindestens verdoppeln.

Schnell wachsender Verbrauch

Die Rechenzentren, die die KI möglich machen, weisen einen zunehmend wachsenden Energieverbrauch auf, was nur noch mehr zu bereits katastrophalen Umweltproblemen beiträgt.

Klimakrise

Befürworter von KI behaupten, dass ihr Einsatz bei der Lösung anderer Probleme im Zusammenhang mit der Klimakrise helfen wird, darunter auch effizienter Ressourcenverbrauch sowie andere komplexe soziale Probleme.

CO2-Emissionen

Dennoch stößt die KI eine bedeutende Menge an CO2 aus, eine treibende Kraft für den Klimawandel. Kritiker merken an, dass dies dem Gegenteil der gesetzten Ziele entspricht.

Entspricht dem Verbrauch von Industrieländern

Konservative Schätzungen deuten darauf hin, dass der Energieverbrauch von KI dem von Industrienationen entspricht. Ohne eine eindeutige Lösung in Sicht, wie dieses Problem gelindert werden kann, wird es weiter fortdauern.

Nachhaltigkeit

Die KI funktioniert größtenteils durch Rechenzentren, aber auch durch Hardware, die ebenfalls Probleme in Sachen Nachhaltigkeit in der Herstellung und Nutzung aufweist.

Inferenz

Auch wenn die Inferenz-Phase der Nutzung einer KI selbst nicht viel Energie verbraucht, summiert sich die dauerhafte Nutzung auf. So führten die Rechenzentren von Facebook 2022 beispielsweise Milliarden von Inferenzen pro Tag durch.

Algorithmen

Diese Inferenzen stammen von Algorithmen wie unter anderem der Funktion für Empfehlungen. Das bedeutet, dass jedes Mal, wenn sich ein Facebook-Nutzer, von denen es über drei Milliarden gibt, auf der Plattform einloggt und den Newsfeed ansieht, Inferenzen ausgelöst werden.

Bestätigen Sie, dass Sie kein Roboter sind

Und das ist nicht nur bei Facebook so. Bei der Bestätigung auf Webseiten, dass der Nutzer ein Mensch ist, bei denen häufig Objekte in Bildern erkannt werden müssen, kommt derselbe Prozess zum Einsatz.

Entwicklung

Auch wenn App-Entwickler den Energieverbrauch in der Entwicklungsphase berücksichtigen, haben Studien gezeigt, dass der Verbrauch bei der alltäglichen Nutzung deutlich höher ist.

Emissionen

Die Organisation Algorithm Watch nutzt das BLOOM-Modell als Beispiel. Während der Entwicklungsphase verbrauchte die App 24,7 Tonnen CO2, wobei die Emissionen der Herstellung der Hardware und des Betriebs nicht einberechnet sind, was die Emissionen dem Doppelten des angegebenen Werts näherbringt.

PaLM

Ein weiteres Beispiel, das die Organisation herausstellt, ist das KI-Sprachmodell von Google, PaLM. Auch wenn fast 90 % der Energie für PaLM aus kohlenstoffneutralen Quellen stammt, führte ein einzelner Test in der Entwicklungsphase zu 271,43 Tonnen an CO2-Emissionen.

Bedeutende Menge CO2

Diese Menge an CO2-Emissionen entspricht eineinhalb kommerziellen Flügen in den USA. Das mag zwar nicht viel erscheinen angesichts der Zahl an Flügen, die täglich in den USA stattfinden, ist aber dennoch eine bedeutende Menge an CO2.

Vergleich

Das gilt insbesondere, da PaLM im Vergleich zu einigen Wettbewerbern ein nachhaltigeres Modell sein soll.

Rechenleistung

Zusätzlich zu den Emissionen basiert KI auf Rechenleistung. Diese verbraucht natürlich Energie. Die Server werden heiß und müssen dauerhaft gekühlt werden, um nicht zu überhitzen.

Wasserverbrauch

Hier kommt Wasser ins Spiel. Zur Kühlung von Stromkraftwerken und KI-Servern wird Süßwasser verwendet. Algorithm Watch gibt an, dass für Sprachmodelle wie GPT-3 und LaMDA allein in der Trainingsphase Millionen Liter Wasser verbraucht werden.

Mehr Wasser nötig

Das Wachstum und die wachsende Nachfrage nach KI-Systemen bedeuten, dass immer mehr Wasserinfrastruktur nötig wird. Die Zahlen sprechen für sich selbst. Der Wasserverbrauch von Google stieg in nur einem Jahr um 20 % an, während der von Microsoft um 34 % stieg.

ChatGPT

Zunehmend beliebte KI-Tools wie ChatGPT verbrauchen allein für ein paar Fragen und Antworten 500 ml Wasser. Bei mindestens 100 Millionen aktiven Nutzern ist der Wasserverbrauch von ChatGPT allein alarmierend.

KI und Nachhaltigkeit

Es dürfte klar sein, dass der tatsächliche Energieverbrauch von KI korrekt dokumentiert werden muss, aber er muss auch festgesetzt und reguliert werden. Allein in Sachen Nachhaltigkeit geht von KI ein großes Risiko aus.

Schränkt die rechtliche Regulierung KI ein?

Einige Kritiker befürchten, dass rechtliche Maßnahmen und Prüfungen die Entwicklung und Innovation von KI behindern könnten, aber die Beschränkung des Energieverbrauchs ist unerlässlich.

Verhindern, dass KI unzugänglich wird

Laut der Hebräischen Universität ist es zentral, den Energieverbrauch zu verringern, da sonst das Risiko besteht, dass KI zu einem Werkzeug für Reiche werden könnte.

Maschinelles Lernen

Da KI auf Basis von maschinellem Lernen funktioniert, wird dafür immer eine Menge Energie zum Training und Betrieb der Modelle nötig sein.

Parameter nötig

Es ist eindeutig, dass für die Fortführung von KI einige Parameter nötig sind, um sicherzustellen, dass wir die Vorteile auch auf lange Sicht nutzen können. Mechanismen zur Überwachung, um den Verbrauch von Ressourcen, CO2-Emissionen und in der Hardware-Produktion zu verstehen, sind zentral.

Unzugänglichkeit

Es besteht die Sorge, dass jegliche Regulierung die Bedingungen zu unzugänglich macht, dass dies zu Grenzen führt, wer KI-Modelle erstellen und nutzen kann.

Architekturelle Veränderungen nötig

Einige ExpertInnen sind der Meinung, dass die KI-Branche groß angelegte architektonische Veränderungen vornehmen muss, die den Umweltbelangen Rechnung tragen und gleichzeitig effizientere Ansätze für die Bedürfnisse der Branche bieten.

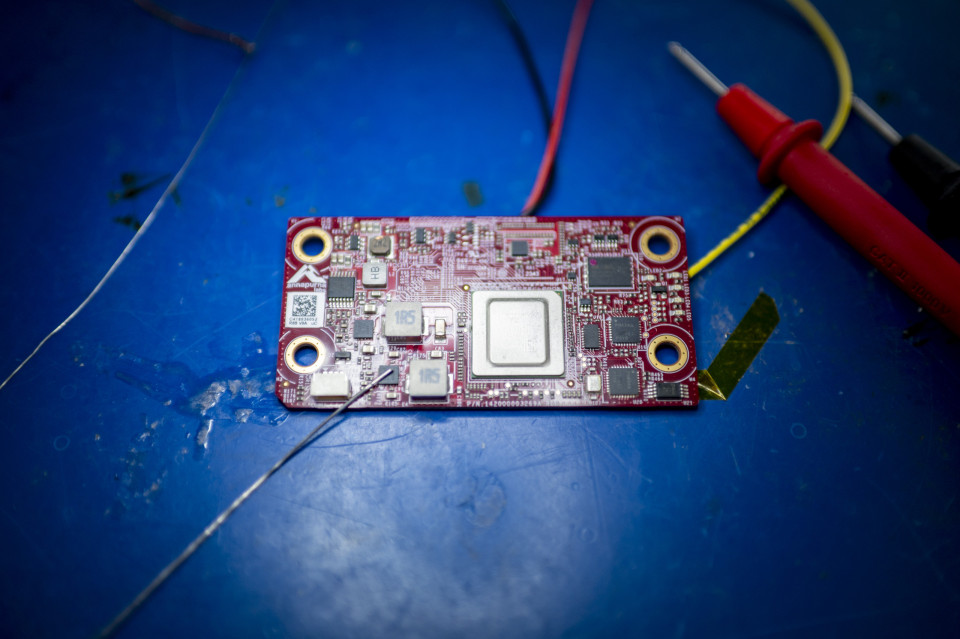

Entwicklung der Hardware

Diese Anpassungen gelten auch für die Entwicklung von Hardware. Unternehmen müssen womöglich darin investieren, technische Tools wie Computerchips effizienter zu machen.

Speicherzugriff

In Googles Umweltbericht von 2024 heißt es, dass sich die Kohlenstoffemissionen in den letzten fünf Jahren allein um 50 % zugenommen haben und die von Microsoft um 30 %. Einer der größten Energieverbraucher ist der dauerhafte Bedarf an Speicherzugriff von KI.

Effizientere Schaltkreise

ExpertInnen geben an, dass der Schlüssel zur Verringerung des Energieverbrauchs in der Suche nach einem energiesparenderen Speicherzugriff und der Entwicklung von effizienteren Schaltkreisen liegt.

Investment nötig

Dies ist ein langer und teurer Prozess, der große Investments in die Forschung nötig machen würde. Daher sind ExpertInnen nicht der Meinung, dass Unternehmen schnell nach Energielösungen suchen werden, sondern ihre KI-Dienste weiter ausweiten werden, solange es noch keine klare Regulierung gibt.

Quellen: (Nature.com) (Algorithm Watch) (Fierce Network) (Wired)

Auch interessant: Im Wettlauf um die KI: Amerikas Plan, um China auszustechen